在创建背景和功能之前,大多数Internet用户使用搜索方法,该方法从WWW服务器的URL开始并连接到链接上的其他URL超文本(超文本链接)。是,由于世界上大量的WWW服务站点,手动搜索需要大量的时间和资源,HTML文件的收集,排序,编译和维护非常费力。方法非常慢并且会定期更新。器人Robot或Spider出现于1994年。的功能是根据特定策略在Web上自动搜索和获取远程数据,并生成本地索引。于不需要人工干预,它可以自动在网络中导航,速度,覆盖范围和速度都得到极大提高。器人收集并自动索引系统,无需额外的人为干预。

系统的主要特征是使用索引策略,索引策略由软件自动收集和索引,以确定网站和网页的顺序,而不是手动收集和索引它们。句话说,Robot会自动在WWW,Gopher和FTP网站上搜索Internet上的资源,返回相应的数据,对其进行索引并生成数据库。器人是一种计算机程序,其最重要的功能是使用索引策略来索引问题,URL,关键字或这些元素的组合。Robot的原理和实现是一个程序,可以浏览链接上的Web文档集合。通常驻留在服务器上。用给定的URL,它可以使用标准协议(如HTTP)读取相应的文档,然后使用文档中包含的所有新(未访问)URL作为新的起点。续前进,直到没有新的URL符合条件。此,通过提供URL,用户可以跟踪和发现从URL直接或间接访问的所有文档并对其进行索引。于机器人的搜索引擎通常定期访问大多数先前收集的网页,刷新索引以反映网页的更新,删除一些非活动链接以及一些内容和对网页的更改。页将反映在用户查询的结果中。是基于机器人的搜索引擎的一个重要特征。些搜索引擎的代表是:AltaVista,Northern Light,Excite,Infoseek,Inktomi,FAST,Lycos,Google。家代表是:天网,优优,OpenFind等。通常有效:首先,机器人自动搜索软件访问一个站点,然后通过链接(通常到三级页面)读取站点页面,然后从站点获取的信息形成于庞大的网页信息数据库。备用户查询。用户通过查询内容进行搜索查询时,软件会在其数据库中找到相关内容,然后根据既定规则对其进行排序。个搜索引擎的排序规则是不同的,包括网站内容与查询条款的相关性。索引擎如何确定网站的内容?当自动Search Appliance访问网站时,它通常执行以下操作:检索页面标题的关键字,从页面的元标记中检索关键字和描述字段;文本,尤其是文本前250个单词中搜索词的出现次数。于上述结果,搜索引擎确定网站内容相对于查询条款的相关性。键字或搜索字词出现的次数越多,搜索查询的网页越相关,搜索引擎的排名就越高。

于互联网上的大量数据,在机器和网络的当前条件下,搜索引擎只能收集某些网站上的数据。外,搜索的索引策略是不同的,因此对不同的研究人员执行相同关键字的搜索。

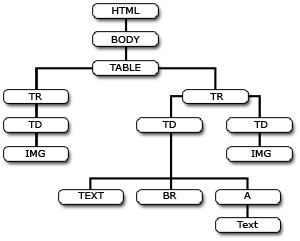

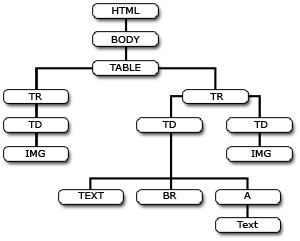

能会有非常不同的结果。果您将Internet视为图形或树形,您会发现Robot技术的工作原理与人工智能搜索树的工作原理相同:它可以在计算机的帮助下轻松实现递归方法:(1)从主页搜索。根据下一页(3)的第一页的第一个链接,等同于搜索树(2)的根,重复(1)和(2); (4)到一个没有链接的页面,

宁波网站优化返回上一级以下链接到页面,这样循环。是,要构建完整的索引数据库,必须遍历WWW系统。而言之,Robot可以系统地和定期地访问Web,从而允许更完整的索引库并使其保持最新。导航过程中,为了提高效率,它可以与人工智能方法集成,使其智能化,搜索引擎更贴近用户。能和问题由于Robot可以快速定期浏览Web以获取最新信息,因此基于机器人的资源发现工具通常可以构建和维护大型索引数据库。

点是信息量很重要,更新速度快,无需人工干预。点是返回的信息太多而且无关信息很多,用户必须过滤结果。可以自动从Internet上的网页收集数据并在本地数据库中丰富它们,定期检查网页是否更新或链接是否无效,并且有必要比较重复信息。多内容在互联网上重印,以及许多重复的信息。要大量处理和动态网页反复更改也会影响它们的工作方式。统的数据搜索只是搜索自己数据库的内容,或者用户在数据库中记录的信息,信息量太小。如,Alta Vista索引数据库包含3100万个网页,Excite包含大约5000万个网页,Lycos包含近7000万个URL索引,依此类推。

些工具在实际应用中非常流行,因为它们在网页上包含大量信息。为一个程序,Robot可以在Unix,Solaris,Windows,NT,OS2和MAC等平台上运行。是,机器人的设计是否合理将直接影响其网络访问效率和搜索数据库的质量。外,在设计机器人时,还应考虑其对网络和访问站点的影响,因为机器人通常在高带宽快速主机上运行。果它快速访问较慢的目标站点,则会导致阻止甚至停止站点。器人还必须遵循某些协议,以便访问站点的管理员可以确定可访问的内容。器人软件是WebRD获取数据的主要方法,虽然它目前被广泛使用,但它带来了许多问题。先,Robot对各种Web站点的频繁访问对网络及其访问的Web服务器造成很大影响,然后在Robot上不加选择地搜索所有可访问的文档并对其进行索引,通常构成索引数据库。三,信息检索算法的选择和设计将直接影响采集引擎的效率。四,基于机器人的搜索引擎必须随着互联网的发展不断扩展其网络数据库。在许多技术问题,例如获取新网页和按时更新数据库,以及在数据库最大化时降低查询效率。前没有解决这些问题的实用方法,它只能依赖于精心设计的并行处理技术。果只从远程位置获取数据,则实现机器人并不困难。是,由于每个机器人都与某些索引和恢复技术相关联,因此它必须与其他模块一起使用。此,在实现中必须考虑许多相关技术,例如HTTP,HTML,分词技术,数据存储和CGI公共网关接口。中,HTTP和HTML是实现Robot的最基本的关键技术。们的研究和实施将极大地提高信息发现和检索系统的性能,提高用户查询率,并改善在线信息资源的使用。▲参考文献赵丹群。于Web资源发现工具的技术分析,信息学报,1999(2)。雪松上网导航技术,黑龙江通信技术,1999。3)。

龙飞Web数据库技术与应用。

代计算机,2000(2)张凯洲等网络信息研究系统开发技术,信息科学学报,2000(2)(作者:扬州大学图书馆兖州路图书馆,扬州225001)"

本文转载自

宁波网站优化www.leseo.net

补充词条:

宁波seo外包

宁波网站排名优化

宁波seo优化公司

宁波网络seo

宁波谷歌seo