搜索引擎技术可以从网络中的海量信息中获取我们想要的信息,随着网络信息资源的快速增长,其作用也越来越明显。文介绍了搜索引擎技术中的Web蜘蛛,分析了其文件处理方法,并回顾了其搜索和更新策略。键词:搜索引擎,网络蜘蛛,更新策略 - 蜘蛛网蜘蛛网操作原理,即。互联网视为一个大蜘蛛网。过搜索引擎中的链接搜索信息的过程看起来像是在这个网络上爬行的蜘蛛。络蜘蛛使用网址来查找网页。从一个起始链接开始,检索网页的内容,然后在网页上收集它,并使用这些链接作为下一次分析的链接地址,循环直到达到某个停止条件。止条件的设置通常基于时间或数量,有时链接的层数用于限制蜘蛛的操作。个网络蜘蛛与网站互动,网站通常会查找特殊的文本文件Robots.txt,如果存在,通常会放在网站的根目录下。是一个专门用于与网络蜘蛛交互的文件。将站点管理器的含义传递给访问它的Web蜘蛛,指示站点接受或禁止某些或所有蜘蛛访问站点上的特定网页或目录。的结构和语法相对简单,一般蜘蛛可以很容易地理解网站的含义。常的搜索引擎可以通过阅读此文件并根据站点管理员的指示进行用户友好访问,从而轻松了解站点的含义。

是,它只是网络的合同协议,没有相应的强制手段,也没有相应的惩罚。此,这个协议对观察者有效,但对于不了解生活规则的蜘蛛来说,没有任何作用。页的元字段也可以放在与上述文件相同的实用程序中。可以告诉网络蜘蛛网站是否应该包含或只是查看或不允许网站管理员。

字段通常位于文档的顶部,通过阅读它,蜘蛛可以在不读取所有文档的情况下理解文档信息,并避免获取无效的网页并将其删除。成不必要的浪费这条规则没有特别的限制:合规程度完全取决于蜘蛛的意识和网站的设计。了允许搜索引擎搜索网站,特别是那些网站所有者希望收集蜘蛛的网站,网页设计师通常会在网站上放置一个名为sitmap.htm的网页,将它用作网站的输入文件。个用于文件处理的web蜘蛛(一)网络处理二进制文件,除了大量的HTML文件和XML文件外,还有大量的二进制文件。了使网页的内容更加丰富,网页大量引用图像和多媒体文件。们也在网页上显示为超链接。此,它们被放置在队列中,以便在链接的提取阶段进行查阅。终确定跨文件内容的文件索引是不现实的,因为当前的技术尚未达到可以使用二进制文件理解文件内容的程度。果,这些文件的处理通常是分开处理的,并且对内容的理解完全取决于二进制文件的锚描述。的描述通常表示文件的标题或基本内容。信息通常是通过引用网页而不是二进制本身来提供的。于类型的不同,二进制文件也必须单独处理。(2)处理脚本文件这里提到的脚本文件通常是指网页中包含的客户端脚本,它将在网页下载到客户端时运行,并且通常在客户端上执行简单的交互式作业。客。

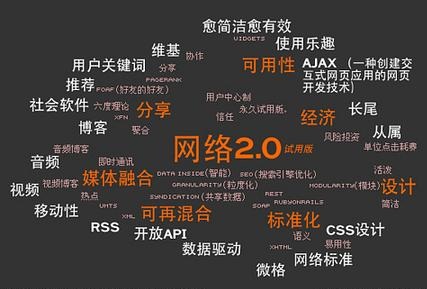

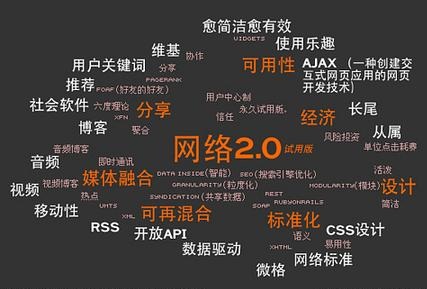

本文件通常负责在网页中显示网页,但由于广泛使用ajax技术,它还负责与服务器的交互。于脚本语言的多样性和复杂性,其分析和处理归结为创建简单的网页解析器。于处理脚本文件非常困难,许多小规模搜索引擎往往会直接省略处理。是,由于网站设计师对非刷新页面的要求有所提高以及ajax技术的广泛使用,ajax技术的处理将是一个巨大的浪费。(3)不同的文件类型处理Web内容的提取和分析一直是网络蜘蛛的重要技术环节。了在Web上处理不同类型的文件,Web蜘蛛通常使用插件来管理它们。有一个更智能的插件管理器,

宁波seo可以处理不同的插件,并为要处理的不同类型的文件调用不同的插件。用插件形式主要用于可扩展性。Internet上有许多类型的文件,不同的文件必须以不同的方式管理,网络不断变化,并且可能随时出现新类型的文件。做到这一点,最简单的方法是为新类型编写一个新插件,然后将其直接发送到虚拟机管理程序。时,插件更好地由新文件格式的制造商编写,只有制造商通常知道新格式定义的含义。析四种Web蜘蛛的策略(I)搜索策略Web蜘蛛的搜索策略指示如何根据输入的URL选择访问地址的标准或规则。将指导运行蜘蛛程序的下一步。究策略通常涉及深入的研究策略和深入的研究策略。一次搜索宽度是最简单的图搜索算法。据结构通常基于先进先出队列结构。理和实施非常简单。通常被认为是盲目搜索。是一种贪婪的搜索策略,优先寻找更多页面。

首先读取文档,保存文档中的所有链接,然后读取所有链接的文档并按顺序继续。样做的好处是它避免了不断访问该服务器文档的可能性,因为文档的链接通常会有几次跳转到其他服务器,这对避免任何问题非常有利。响。他服务器工作。方法也常用于目标爬行动物。本思想是,从链接到原始URL一定距离的网页很可能具有主题相关性。也允许尽可能多的服务器使索引服务器收集文档。的缺点是难以进入文档,并且随着扫描页数的增加,将下载和过滤大量不相关的网页,并且算法的效率变得非常低。度搜索策略首先从堆栈以高级方式处理URL。络蜘蛛分析文档并获取其第一个链接指定的文档以继续分析,然后继续。的优点是它可以更好地穿透和探索场地的结构。算法非常稳定,效率也得到保证。对寻找小型网站很有帮助。的问题是显而易见的:短时间内不断访问同一服务器的问题将非常严重,并且很容易陷入文档树的无限循环,这种算法处理这个问题的能力是相当的有限。合两种算法也是明智的,这两种算法的长度不同,可以在某些地方完成。法是主要方法,并且补充算法的算法可以具有彼此互补的效果。

了上述算法之外,最好使用优先级算法,该算法对通过某些算法收集的链接进行排序以获得页面的质量和效率,并且将首先分析最佳算法。是这个算法的质量和效率有很多版本,这里不详述。了这些常用算法外,还有一些不常用的优秀算法,如哈希算法,遗传算法等。(2)策略索引中大量网页的更新很少改变:绝对不必以相同的频率统一更新所有网页。此,根据网页更改的周期,仅更新频繁更改的网页也是小型搜索引擎使用的常用方法。是,仅更新某些网页可能会错过某些重要网页的更新。

此,Web爬网程序通常采用单独的更新策略。根据对各个网页所做的更改频率确定网页更新的频率,以便每个网页具有独立的更新频率。然它与更新网页基本相同,但它在逻辑上是最合适的,但它为每个网页维护不同的频率,在不同时期更新几页并加快速度更新频率。小时更新次数减少,这对系统来说是相当大的浪费。

了解决这种情况,这些频率可以分为几个级别,快速更新和慢速更新被分成几组,然后每组接收平均值的折扣频率,每个频率的频率不同。

一的更新集合可以平衡上述矛盾,以获得更好的结果。

本文转载自

宁波seowww.leseo.net

补充词条:

宁波网站seo优化

宁波seo网站优化

宁波seo外包

宁波谷歌优化

宁波网络seo公司