根据在实施,组织和主题搜索引擎结构的具体问题用户的需求都需要深入研究和信息采集模块的主题是根据目前的情况设计的。

[关键词]荷兰搜索引擎[文献代码] DOI:10.3969 / j.issn.0450-9889(C).2011.06.051 2009年以来,搜索引擎已经进入了快速发展的新阶段。2010年上半年,首先,程度和搜索引擎用户的渗透率持续增长;其次,使用搜索引擎的频率有所增加,获取生活中的各种信息对互联网和搜索引擎更具吸引力。索引擎行业引发了一场无形的烟雾战争。们希望搜索引擎能够更准确地返回所需的信息。主题搜索引擎已成为未来搜索引擎的趋势。

前,每年有数百万大学毕业生毕业,教育部宣布,2010年大学毕业生人数将达到630万。

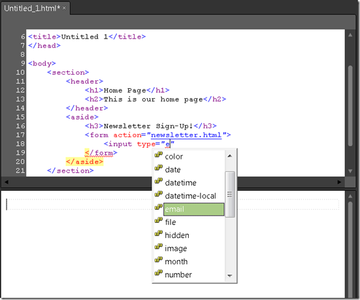

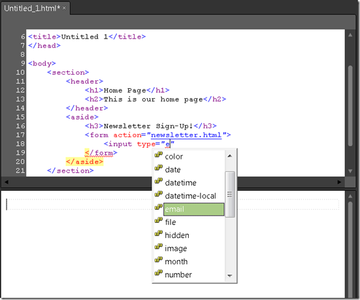

业生希望能收集大量的招聘信息,以便尽快找到合适的工作,这就是为什么它是非常有用的制定上的招聘信息主题的搜索引擎。Nutch简介该系统的设计是在Nutch上开发和设计的。Nutch是一个基于Lucene完整搜索引擎的完整Java应用程序系统。

Nutch开源,程序员很容易通过修改源代码,通过Tomcat等Web服务器重新发行Nutch。统功能分析系统需求分析招聘信息主题搜索可以为需要的信息检索用户提供招聘信息,工作要求等的搜索功能。工作。度和谷歌之间的区别在于他们可以快速回复用户。体信息。

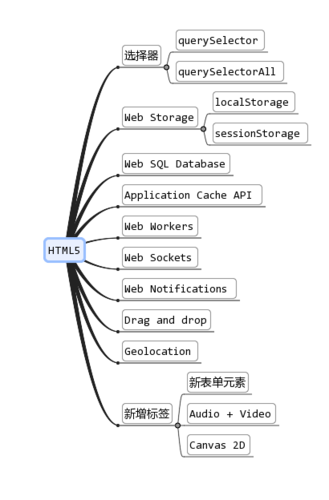

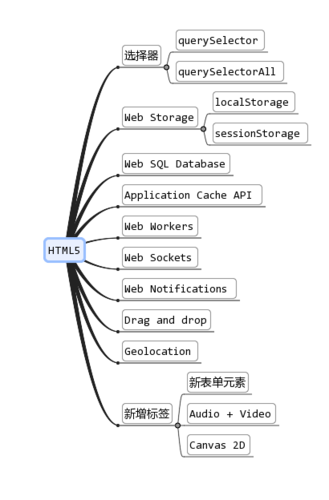

实现一个主题搜索引擎,简单地对待基于通用搜索引擎(主要用户功能需求如图1所示),给定区域资源的话题。过招聘信息主题设计研究设计目标:首先,为了满足主题用户的实际需求,系统收集各种类型的招聘信息和工作信息。户,包括公司名称,工作场所和工作场所。资处理,联系信息等其次,系统开发是招聘信息的一个特定主题。通用搜索引擎返回的结果相比,结果更准确,更集中,更快。文分词技术概述,中文分词设计和Nutch原始分词增强。备分割的精度。三,它为用户提供了用户友好,易于使用的界面。究信息的搜索引擎设计的总主题是基本相同的通用搜索引擎,从而使系统的设计是基于通用搜索引擎和数据采集模块相关联在网络上招聘信息。容被收集和信息提取模块提取所收集的信息,并将它们发送到分割模块和存储词语chinois.Le索引模块存储在数据库中的索引,并将其存储指数。

户可以将请求提交给提取模块。从索引数据库中检索相应的结果,并将结果返回给用户。系统的一般结构示于图2,根据系统结构的整体设计中,系统定期进入一定的时间间隔内的网络的网页有效的信息,执行对信息字的分段捕获的网页,构建索引并将其存储在索引数据库中。

用户请求请求之后,根据分词处理请求指令,映射索引数据库的索引数据并检索获得的匹配信息然后排序,然后以结果页面的形式返回给用户。题拍摄主题设计,信息采集网络上的设计主题设计信息和机器人主题流程来收集网络资源的过程中有针对性的,一旦收集到的信息,经过分析,提取和其他处理,传递到索引索引模块,最终用户可以通过恢复模块恢复相关的请求,即引擎的整个工作流程按主题搜索,这将影响主题的搜索引擎的性能。器人工作流程的主题图3.机器人主题工作的流程是先收集初始启动网站的信息,进行分析和处理网页的页面显示获取,检索URL并确定相对于主题获得的网页的页面和URL的相关性(如果有的话)。果停止的条件满足时,

宁波网站优化收集任务是根据研究策略继续收集数据停止,如果不是这样的情况下,选择了具有更高优先级的网址信息。题机器人的任务是收集尽可能多的与主题相关的页面以涵盖主题。此,专题机器人的设计主要基于以下两个方面:下载与主题相关的网页。

于由主题的搜索引擎,一旦用户提交一个查询请求的系统,信息返回给用户必须遵守尽可能的需求,而不是发送大量的无用信息。

此,主题资源管理器的任务不是在因特网上收集尽可能多的信息,而是尽可能多地下载与该主题相关的网页。定主题机器人的搜索策略。题爬虫在访问URL的过程中与通用搜索引擎的主题爬虫不同。用搜索引擎的爬虫不必确定被分析的页面是否与主题相关并且考虑尽可能多的下载页面。集信息。收集关于URL处理信息,有必要考虑网页的相关性基础上的关联度分析的主题,并确定URL分析阶次分析主题。

题机器人的目的是完成主题信息的收集,旨在通过机器人功能扩展到一般搜索引擎。

图4中所示的主题信息捕获过程的设计该系统的设计,并作为信息recrutement.Le信息捕获模块的受试者搜索引擎实现的第一提供的列表关键字和网站集。

题机器人基于初始起始站点获取信息并将其提交给主题过滤模块。滤器。择原始URL和关于蜘蛛的主题的信息通常是基于给定的输入地址的初始种子网站的收集,以及初始起始位点的选择将直接影响信息收集的结果。择参考站点时,尝试在主题字段中选择具有高度权限的站点,并确保主题爬网程序可以收集高度相关的主题资源关于从这些网站集移动的主题。择此搜索引擎的原始URL使用混合模式,即手动分配与自动生成相结合。先,使用简单的元搜索策略在百度上获取某个链接地址,然后过滤,过滤等。动,提取某个链接地址。过地址分析,您可以获取这些地址的目录或顶级网站,然后加入知名的招聘网站。搜索策略的实现主要由HTMLParser执行。

HTMLParser是一个功能强大,快节奏且流行的HTML解析器。本质上是一个用于网页分析的开源Java库,主要用于分析HTML网页和完整内容提取。用HTMLParser提取链接非常有效,并允许您快速提取网页中链接的地址。里是一个局部码以提取关于使用的HTMLParser百度链接:公共静态无效的主要(字串[] args){尝试{ParserException向上TravelWordTable(“关键字表”);}赶上(例外五){È .printStackTrace();}} //阅读元搜索主题关键字关键字文件...公共静态无效TravelWordTable(字符串文件名)抛出IOException异常{{尝试字符串缓冲区; FileWriter resultFile = null; PrintWriter myFile = null; String dstfile = Filename +“_ dsturl.txt”;文件writefile =新文件(dstfile); writefile.createNewFile如果{();}(!Writefile.exists())resultfile =新的FileWriter(WriteFile的); myFile = new PrintWriter(resultFile);的BufferedReader读者=新的BufferedReader(新的FileReader(文件名);而((缓冲液= reader.readLine())!= NULL){字符串URL =“http://www.baidu.com/s?lm=0&si=&rn = 10&y = GB2312&CT = 0&WD = “+缓冲液+” &PN = 0&版本= 0&CL = 3 “getBaiduUrls(URL,” GB2312“MYFILE);}} ......种子一旦定义来看,种子库必须维护和更新régulièrement.Le中国分词模块设计,让系统能够正确段中国话,提高搜索引擎的精确度通过thèmes.Le系统搜索使用这个词我是分割的软件。分析的基本特点是英文分割的支持,数字,中国(简体)混合的话,超过220万个字的词汇还提供了API,这增加了字典的动态开发,组织和优化同义词字典nymes并完全支持Lucene;您可以设置正匹配单词的最大数量。的分词效率达到每秒300,000字。JE分词基于词库的分词。义词词的分词基于给定的词典,并根据算法在词典中找到相应的词,然后进行分段。

词JE中使用的算法是MM方法。

本思想如下:设D为字典,M表示字典D中最长条目的长度,并且str为要分割的句子。算法必须MM的M-长度字符串str切割字典的术语D.如果匹配成功,则链短,指针移回M字符和链的长度相匹配连续提取M以继续对应于字典D.如果匹配不成功,则从最后一个字中减去相应的字符串。后继续匹配,直到字符串匹配所有内容或短语为空。

本文转载自

宁波网站优化www.leseo.net

补充词条:

宁波网站seo优化

宁波seo哪家好

宁波网络seo

宁波网络seo公司

宁波谷歌优化