随着大数据的出现,获取和检索信息尤为重要。何快速准确地获取大量数据所需的内容非常重要。过对Web浏览器和深入与Redis的,一个NoSQL的数据库构建分布式爬虫的框架和Django框架创立一个引擎网站的相关Scrapy的探索研究搜索,有效信息将从志湖,拉赫,博乐等网站捕获。

储在ElasticSearch搜索引擎中,以便用户可以搜索它。果表明,分布式Web爬虫比独立爬虫更高效,更丰富,更准确。键词:网络爬虫; scrapy;分布; Scrapy,Redis的; Django的; ElasticSearch中图分类号:TP311文献标识码:A文章编号:1009-3044(2018)34-0186-03介绍了爬行动物的范围是非常大的。前,已经有在市场上成熟的搜索引擎,如百度,谷歌和其他垂直域搜索引擎,用于间接目的和一些可以引导给用户的推荐引擎。关新闻,爬虫也可以用作机器学习的数据样本。文的主要目的是了解爬行动物的Python语言的认识和了解,

宁波网站优化更深入,开源的Scrypy框架,它会因别人的理论基础和数据库与爬行动物有关的企业;了解分布式的概念,奠定了大数据的研究和物质条件的基础上,掌握了Python框架来创建一个Django的网站,深入了解基于Lucene ElasticSearch搜索服务器和最终建立基于一个简单的版本以上基础知识。索引擎实现网络数据分析,将其存储在分布式Redis数据库中,最终实现通过Django和ElasticSearch显示搜索的目标。

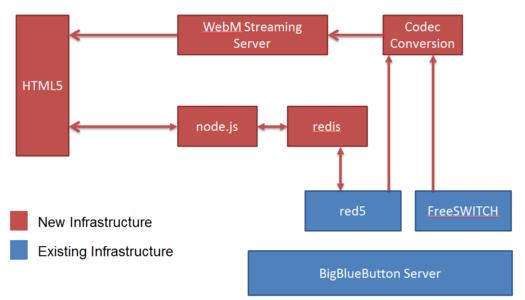

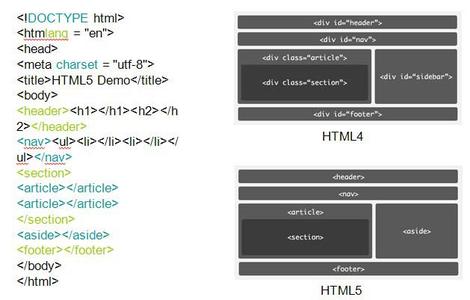

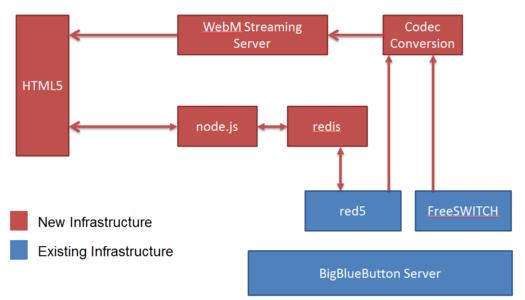

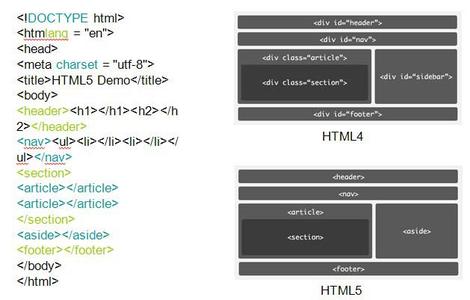

行动物基础Web爬行程序是根据特定规则自动解析Web信息的程序或脚本。果因特网作为大蜘蛛处理时,数据被存储在蜘蛛的各个节点上和爬行动物是小蜘蛛整个网络遍历其猎物(数据)。器人是指在获取资源后向网站发起请求,分析和提取有用数据的程序。技术角度来看,通过程序的模拟浏览器可以请求站点的行为。HTML代码,JSON数据,二进制数据(图像,视频)等。站点返回的内容被转移到本地,然后提取并存储必要的站点数据供以后使用。带的分布式Scrapy-Redis的ScrapyScrapy的原理示于图1:各组分的解释如下:Scrapy发动机(马达):负责蜘蛛ItemPipeline,下载器,规划师,转印之间的通信数据等,相当于人脑。心,机器的发动机等具有显着的效果。度程序:它负责接收引擎发送的请求请求,以某种方式对其进行排序,进入队列并在需要时将其返回给引擎。载程序:下载Scrapy Engine发送的所有请求,并将提取的响应返回给Scrapy Engine,然后将其传递给蜘蛛进行处理。Spider:负责处理所有响应,提取数据,检索Item字段所需的数据,将URL发送到引擎,然后重新进入调度程序。

素管道:负责处理在Spider中获得的元素和执行后处理(详细分析,过滤,存储等)。载中间件:可用作自定义扩展下载功能的组件。间件蜘蛛:它可以被理解为一个功能部件可以自定义扩展引擎和操作与中间通信蜘蛛(例如回应到蜘蛛,以及从蜘蛛请求)。器人启动时,它提取每个start_urls URL,然后收集它成一个查询,它发送给发动机和发动机将其交付给:所述Scrapy机器人结构的整个执行过程可以如下理解队列。后,后者将排队等待新的治疗,然后交付。传到下载器,下载返回的响应文件传递给分析方法进行处理,扫描方法可以直接调用xpath方法提取数据。RedisRedis是一个完全开源,高性能,免费的BSD兼容键值数据库。复和其他键 - 值缓存的产品有以下三个特点:(1)重复支持持久性数据,这允许将数据保存在驱动器的存储器中,并且可以在被加载和再次使用重新启动。可以避免数据丢失,并且必须在实际生产应用程序中保证其完整性。(2)Redis不仅支持简单的键值数据,还存储列表,集合,zset和哈希等数据结构。些功能更强大的数据存储方法可以显着减少存储空间,优化查询性能并显着提高效率。储的目的是稍后改进,Redis做得很好。

(3)Redis支持数据备份,即主从模式下的数据备份。从结构是目前大数据的主要结构,主从模式可以保证鲁棒性和高数据可用性。存在主要的自然原因,例如计算机停机和硬盘损坏时,主从模式可以确保存储的数据不会丢失并且可以恢复到可用状态在任何时候。是由于上面描述的强大的Redis功能,才选择Redis作为分布式存储的数据库。

Django构建了一个搜索站点Django是一个开源的Web应用程序框架,是由Python开发的MVC框架。Django中,接受用户输入的控制器部分由基础结构本身管理。此,更多关注模型,模型和视图,或MVT。

型(数据访问层)管理与数据相关的所有内容:如何访问数据,如何检查有效性,数据之间的关系等等。

图,表示层,管理与性能相关的逻辑,主要是显示的问题。型,业务逻辑层,其主要职责是访问模型并检索相应模型的相应逻辑。制器部分由Django框架的URLconf实现,而URLconf机制只是使用正则表达式来匹配URL,然后调用适当的函数。此,只需要编写少量代码,只涉及业务逻辑部分,这极大地提高了开发效率。过使用Django构建搜索引擎界面,简单方便的界面交互很好,它可以免费满足需求。索引擎ElasticSearch ElasticSearch是基于Lucene搜索引擎和实时分布式分析,专为云计算和实现实时搜索,稳定,可靠,快速,易于安装和使用。于RESTful接口。ElasticSearch拥有广泛的用户,例如DELL,GitHub,Wikipedia等。ElasticSearch与关系数据库之间的夫妇在表1中:ElasticSearch-RTFRTF代表箭在弦上,这意味着飞机模型可以直接不组装零件开始。

ElasticSearch RTF是中国的分布,也就是说,它使用的ElasticSearch,下载最新的稳定版本和测试相应的插件,如中国的分词插件等等目标是直接下载和使用。项目构建期间选择了Elasticsearch-RTF 5.1.1版本。装后,效果如图2所示.Elasticsearch-headElasticSearch-head是一个前端Web插件,用于浏览和与ElasticSearch集群交互。可以作为ElasticSearch插件运行。常优选该方法。为独立的Web应用程序运行。

的通用工具有三个主要操作:ClusterOverview,它提供当前集群的拓扑结构,并允许在索引和节点上进行操作;多个搜索界面可以以本机Json或表格格式查询搜索结果,多个快速访问指示群集的状态。项卡:允许任意调用RESTful API的输入部分。KibanaKibana是一个开源分析和可视化平台,旨在与Elasticsearch协同工作。可以使用kibana使用各种图表,表格,地图等在Elasticsearch索引中交互式搜索,显示和存储数据。Kibana可以轻松演示高级数据分析和可视化。Kibana使您可以轻松理解大量数据。

简单的基于浏览器的界面可快速创建和共享动态仪表板,实时显示Elasticsearch查询更改。动Kibana完成后,就可以看到插入数据和查询页面的结果如图3所示。

束语随着机器人的理论的正确理解,信息的量上海互联网根据需要进行分类和存储,然后显示给特定用户。定区域所需的信息可以避免互联网上大量信息的视觉影响,从而实现准确有效的恢复。

用Python和丰富的知识基础,开源履带Scrapy框架有关,它可以有效地分析互联网上的海量信息,并使用分布式数据库Redis的特点迅速和数据安全存储供以后使用。取和收集,使用开源框架的Django创建一个搜索引擎网站,提供热情友好的可视化界面,使用方便,与ElasticSearch的强大的搜索功能相结合,将所有的组件来完成完成搜索引擎的功能,最终实现搜索的目的。

本文转载自

宁波网站优化www.leseo.net

补充词条:

宁波网络seo公司

宁波seo优化公司

宁波seo排名

宁波seo哪家好

宁波seo网站优化